목표

이 예제에서는 GitHub 이슈의 제목을 기반으로 분류하는 봇을 구축합니다. 이 봇은 제목을 입력받아 여러 클래스 중 하나로 분류합니다. 그런 다음 사용자 피드백을 수집하기 시작하고 이를 사용하여 분류기의 성능을 개선합니다.시작하기

시작하려면 먼저 모든 트레이스를 특정 프로젝트로 전송하도록 설정합니다. 환경 변수를 설정하여 이 작업을 수행할 수 있습니다:자동화 설정하기

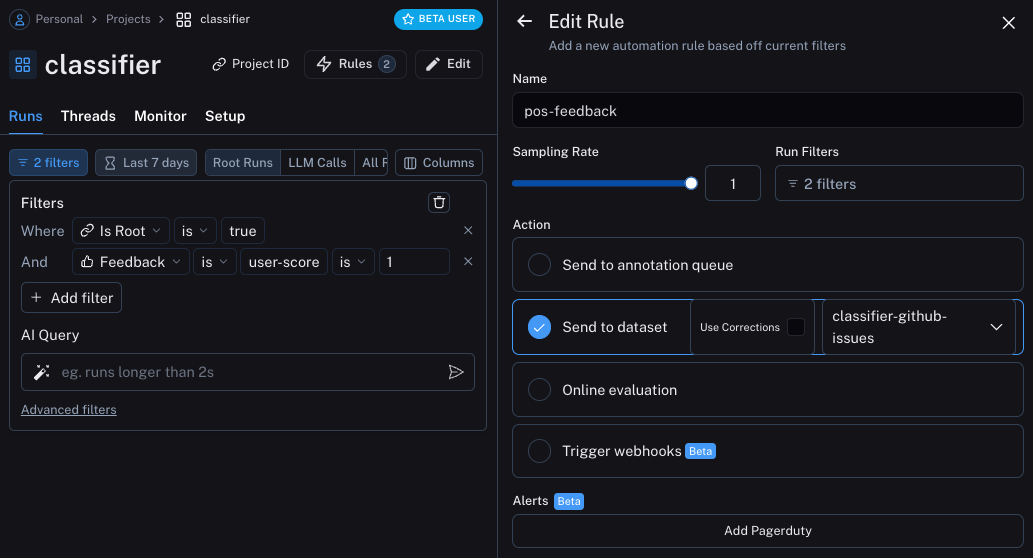

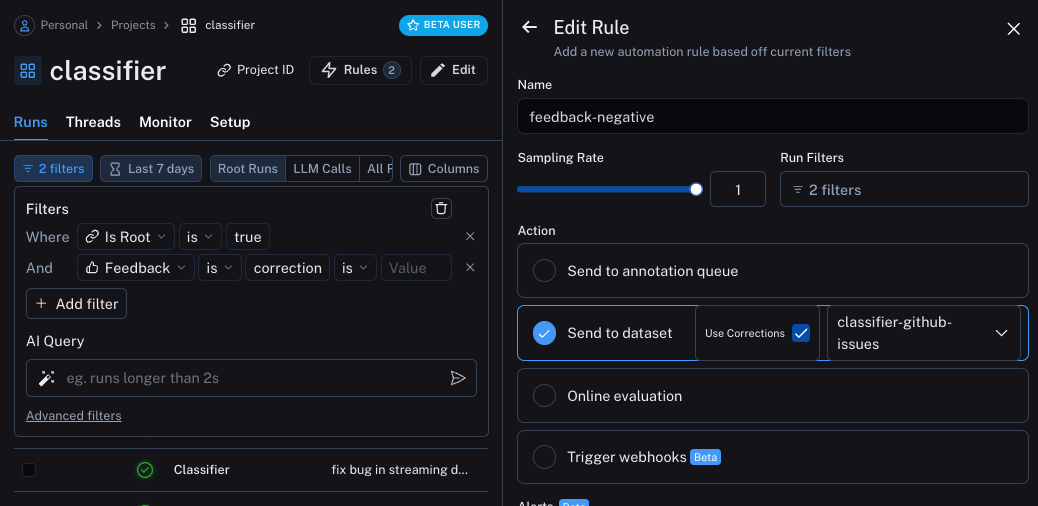

이제 어떤 형태로든 피드백이 있는 예제를 데이터셋으로 이동하는 자동화를 설정할 수 있습니다. 긍정적인 피드백에 대한 자동화와 부정적인 피드백에 대한 자동화, 두 가지 자동화를 설정합니다. 첫 번째 자동화는 긍정적인 피드백이 있는 모든 실행을 가져와서 자동으로 데이터셋에 추가합니다. 이것의 논리는 긍정적인 피드백이 있는 모든 실행을 향후 반복에서 좋은 예제로 사용할 수 있다는 것입니다. 이 데이터를 추가할classifier-github-issues라는 데이터셋을 생성하겠습니다.

애플리케이션 업데이트하기

이제 코드를 업데이트하여 실행을 보내고 있는 데이터셋을 가져올 수 있습니다. 데이터셋을 가져오면 예제가 포함된 문자열을 만들 수 있습니다. 그런 다음 이 문자열을 프롬프트의 일부로 넣을 수 있습니다!documentation으로 분류되어야 한다는 것을 올바르게 학습한 것을 확인할 수 있습니다.

예제에 대한 시맨틱 검색

추가로 할 수 있는 한 가지는 의미적으로 가장 유사한 예제만 사용하는 것입니다. 이것은 많은 예제가 쌓이기 시작할 때 유용합니다. 이를 위해 먼저k개의 가장 유사한 예제를 찾는 함수를 정의할 수 있습니다: