- PII(개인 식별 정보) 유출 방지

- 프롬프트 인젝션 공격 탐지 및 차단

- 부적절하거나 유해한 콘텐츠 차단

- 비즈니스 규칙 및 규정 준수 요구사항 시행

- 출력 품질 및 정확성 검증

결정론적 가드레일

정규식 패턴, 키워드 매칭 또는 명시적 검사와 같은 규칙 기반 로직을 사용합니다. 빠르고 예측 가능하며 비용 효율적이지만, 미묘한 위반 사항을 놓칠 수 있습니다.

모델 기반 가드레일

LLM 또는 분류기를 사용하여 의미론적 이해를 바탕으로 콘텐츠를 평가합니다. 규칙이 놓치는 미묘한 문제를 포착할 수 있지만, 더 느리고 비용이 많이 듭니다.

내장 가드레일

PII 감지

LangChain은 대화에서 PII(개인 식별 정보)를 감지하고 처리하기 위한 내장 미들웨어를 제공합니다. 이 미들웨어는 이메일, 신용카드, IP 주소 등과 같은 일반적인 PII 유형을 감지할 수 있습니다. PII 감지 미들웨어는 규정 준수 요구사항이 있는 의료 및 금융 애플리케이션, 로그를 삭제해야 하는 고객 서비스 에이전트, 그리고 일반적으로 민감한 사용자 데이터를 처리하는 모든 애플리케이션에 유용합니다. PII 미들웨어는 감지된 PII를 처리하기 위한 여러 전략을 지원합니다:| 전략 | 설명 | 예시 |

|---|---|---|

redact | [REDACTED_TYPE]으로 교체 | [REDACTED_EMAIL] |

mask | 부분적으로 가림(예: 마지막 4자리) | ****-****-****-1234 |

hash | 결정론적 해시로 교체 | a8f5f167... |

block | 감지 시 예외 발생 | 오류 발생 |

내장 PII 유형 및 구성

내장 PII 유형 및 구성

내장 PII 유형:

email- 이메일 주소credit_card- 신용카드 번호(Luhn 검증됨)ip- IP 주소mac_address- MAC 주소url- URL

| 매개변수 | 설명 | 기본값 |

|---|---|---|

pii_type | 감지할 PII 유형(내장 또는 커스텀) | 필수 |

strategy | 감지된 PII를 처리하는 방법("block", "redact", "mask", "hash") | "redact" |

detector | 커스텀 감지기 함수 또는 정규식 패턴 | None(내장 사용) |

apply_to_input | 모델 호출 전 사용자 메시지 검사 | True |

apply_to_output | 모델 호출 후 AI 메시지 검사 | False |

apply_to_tool_results | 실행 후 도구 결과 메시지 검사 | False |

Human-in-the-loop

LangChain은 민감한 작업을 실행하기 전에 사람의 승인을 요구하는 내장 미들웨어를 제공합니다. 이는 높은 위험도의 결정에 가장 효과적인 가드레일 중 하나입니다. Human-in-the-loop 미들웨어는 금융 거래 및 이체, 프로덕션 데이터 삭제 또는 수정, 외부 당사자에게 통신 전송, 그리고 상당한 비즈니스 영향을 미치는 모든 작업과 같은 경우에 유용합니다.커스텀 가드레일

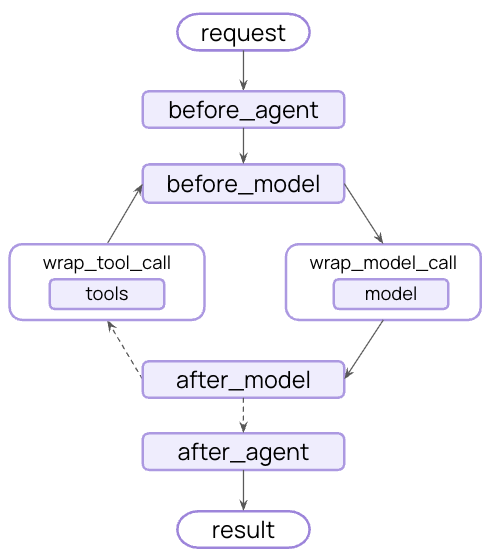

더 정교한 가드레일을 위해 에이전트가 실행되기 전이나 후에 실행되는 커스텀 미들웨어를 생성할 수 있습니다. 이를 통해 검증 로직, 콘텐츠 필터링 및 안전 검사를 완전히 제어할 수 있습니다.Before agent 가드레일

“before agent” 훅을 사용하여 각 호출이 시작될 때 한 번 요청을 검증합니다. 이는 인증, 속도 제한 또는 처리가 시작되기 전에 부적절한 요청을 차단하는 것과 같은 세션 수준 검사에 유용합니다.After agent 가드레일

“after agent” 훅을 사용하여 사용자에게 반환하기 전에 최종 출력을 한 번 검증합니다. 이는 모델 기반 안전 검사, 품질 검증 또는 완전한 에이전트 응답에 대한 최종 규정 준수 스캔에 유용합니다.여러 가드레일 결합

미들웨어 배열에 추가하여 여러 가드레일을 쌓을 수 있습니다. 가드레일은 순서대로 실행되어 계층화된 보호를 구축할 수 있습니다:추가 리소스

- 미들웨어 문서 - 커스텀 미들웨어 완전 가이드

- 미들웨어 API 레퍼런스 - 커스텀 미들웨어 완전 가이드

- Human-in-the-loop - 민감한 작업에 대한 사람의 검토 추가

- 에이전트 테스트 - 안전 메커니즘 테스트 전략