LangChain과 함께 사용하기

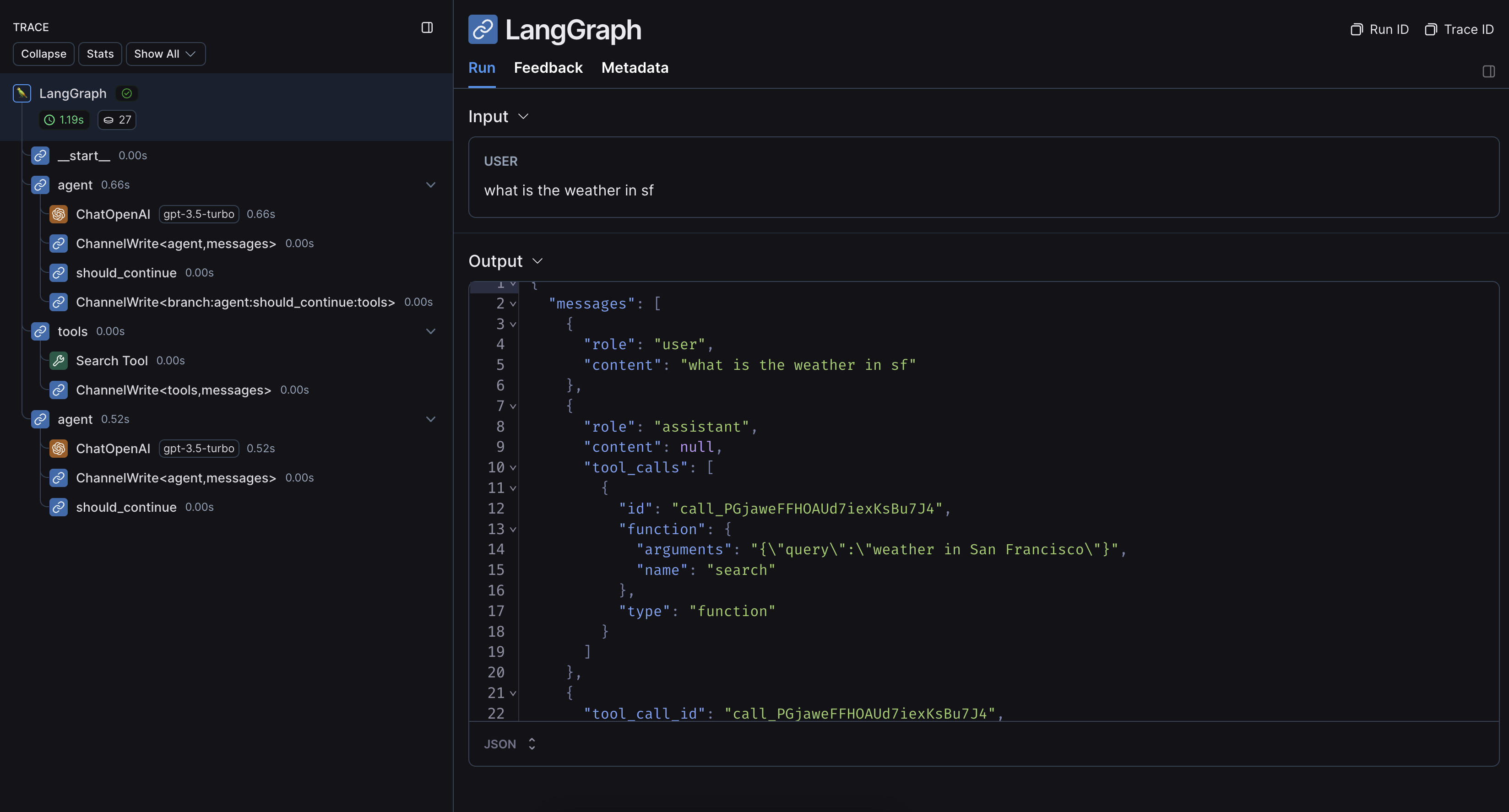

LangGraph 내에서 LangChain 모듈을 사용하는 경우, 추적을 활성화하기 위해 몇 가지 환경 변수만 설정하면 됩니다. 이 가이드에서는 기본적인 예제를 안내합니다. 구성에 대한 자세한 내용은 LangChain으로 추적하기 가이드를 참조하세요.1. 설치

Python과 JS용 LangGraph 라이브러리와 OpenAI 통합을 설치합니다(아래 코드 스니펫에서는 OpenAI 통합을 사용합니다). 사용 가능한 패키지의 전체 목록은 LangChain Python 문서와 LangChain JS 문서를 참조하세요.2. 환경 구성하기

서버리스 환경이 아닌 곳에서 LangSmith와 함께 LangChain.js를 사용하는 경우, 지연 시간을 줄이기 위해 다음을 명시적으로 설정하는 것을 권장합니다:

export LANGCHAIN_CALLBACKS_BACKGROUND=true서버리스 환경에서는 함수가 종료되기 전에 추적이 완료될 수 있도록 반대로 설정하는 것을 권장합니다:export LANGCHAIN_CALLBACKS_BACKGROUND=false자세한 내용은 이 LangChain.js 가이드를 참조하세요.3. 추적 로그 남기기

환경을 설정한 후에는 평소처럼 LangChain runnable을 호출할 수 있습니다. LangSmith가 적절한 추적 구성을 자동으로 추론합니다:

LangChain 없이 사용하기

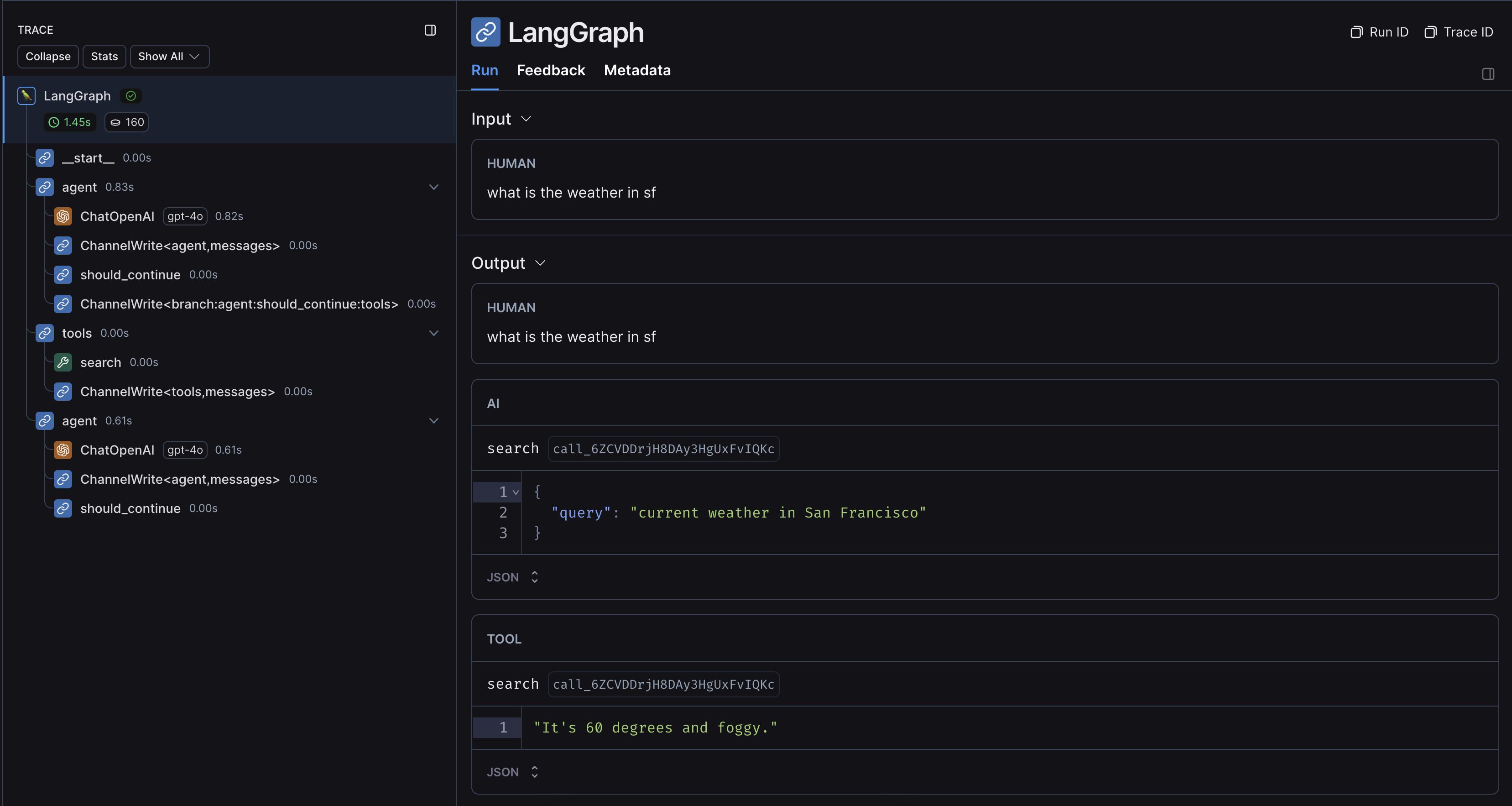

LangGraph 내에서 다른 SDK나 커스텀 함수를 사용하는 경우, 적절하게 래핑하거나 데코레이팅해야 합니다(Python에서는@traceable 데코레이터를, JS에서는 traceable 함수를 사용하거나, SDK의 경우 wrap_openai와 같은 것을 사용). 이렇게 하면 LangSmith가 래핑된 메서드의 추적을 자동으로 중첩합니다.

다음은 예제입니다. 자세한 내용은 이 페이지를 참조하세요.

1. 설치

Python과 JS용 LangGraph 라이브러리와 OpenAI SDK를 설치합니다(아래 코드 스니펫에서는 OpenAI 통합을 사용합니다).2. 환경 구성하기

서버리스 환경이 아닌 곳에서 LangSmith와 함께 LangChain.js를 사용하는 경우, 지연 시간을 줄이기 위해 다음을 명시적으로 설정하는 것을 권장합니다:

export LANGCHAIN_CALLBACKS_BACKGROUND=true서버리스 환경에서는 함수가 종료되기 전에 추적이 완료될 수 있도록 반대로 설정하는 것을 권장합니다:export LANGCHAIN_CALLBACKS_BACKGROUND=false자세한 내용은 이 LangChain.js 가이드를 참조하세요.3. 추적 로그 남기기

환경을 설정한 후, 추적하려는 커스텀 함수/SDK를 래핑하거나 데코레이팅합니다. 그러면 LangSmith가 적절한 추적 구성을 자동으로 추론합니다: