이 사용 가이드에서는 한 가지 유형의 평가자(LLM-as-a-judge)를 설정하고 실행하는 방법을 보여드립니다. 사용 예제가 포함된 사전 구축된 평가자의 전체 목록은 openevals 및 agentevals 리포지토리를 참조하세요.

설정

사전 구축된 LLM-as-a-judge 평가자를 사용하려면openevals 패키지를 설치해야 합니다.

openevals는 evaluate 메서드와도 원활하게 통합됩니다. 설정 지침은 해당 가이드를 참조하세요.

평가자 실행하기

일반적인 흐름은 간단합니다:openevals에서 평가자 또는 팩토리 함수를 가져온 다음, 테스트 파일 내에서 입력, 출력 및 참조 출력과 함께 실행합니다. LangSmith는 평가자의 결과를 자동으로 피드백으로 기록합니다.

모든 평가자가 각 매개변수를 요구하는 것은 아닙니다(예를 들어, 정확한 일치 평가자는 출력과 참조 출력만 필요합니다). 또한 LLM-as-a-judge 프롬프트에 추가 변수가 필요한 경우, kwargs로 전달하면 프롬프트에 형식화됩니다.

다음과 같이 테스트 파일을 설정하세요:

feedback_key/feedbackKey 매개변수는 실험에서 피드백의 이름으로 사용됩니다.

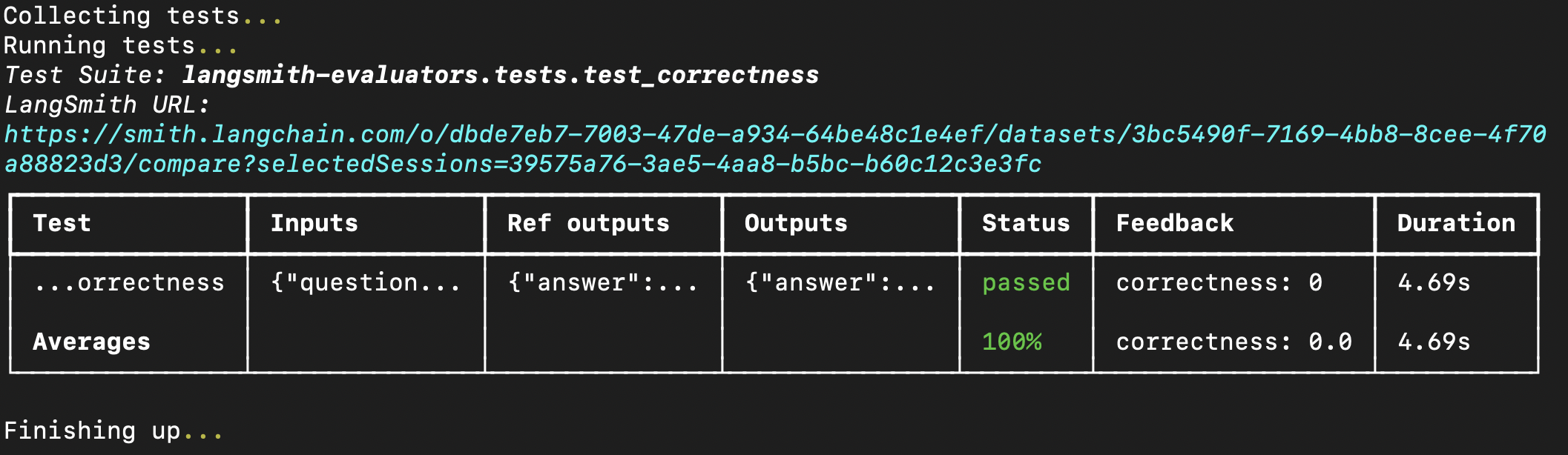

터미널에서 평가를 실행하면 다음과 같은 결과가 표시됩니다:

evaluate 메서드에 직접 전달할 수도 있습니다. Python을 사용하는 경우 langsmith>=0.3.11이 필요합니다: