실험에서 반복 실행 구성하기

evaluate / aevaluate 함수(Python, TypeScript)에 선택적 매개변수인 num_repetitions를 추가하여 데이터셋의 각 예제를 몇 번 평가할지 지정할 수 있습니다. 예를 들어, 데이터셋에 5개의 예제가 있고 num_repetitions=5로 설정하면 각 예제가 5번 실행되어 총 25번의 실행이 이루어집니다.

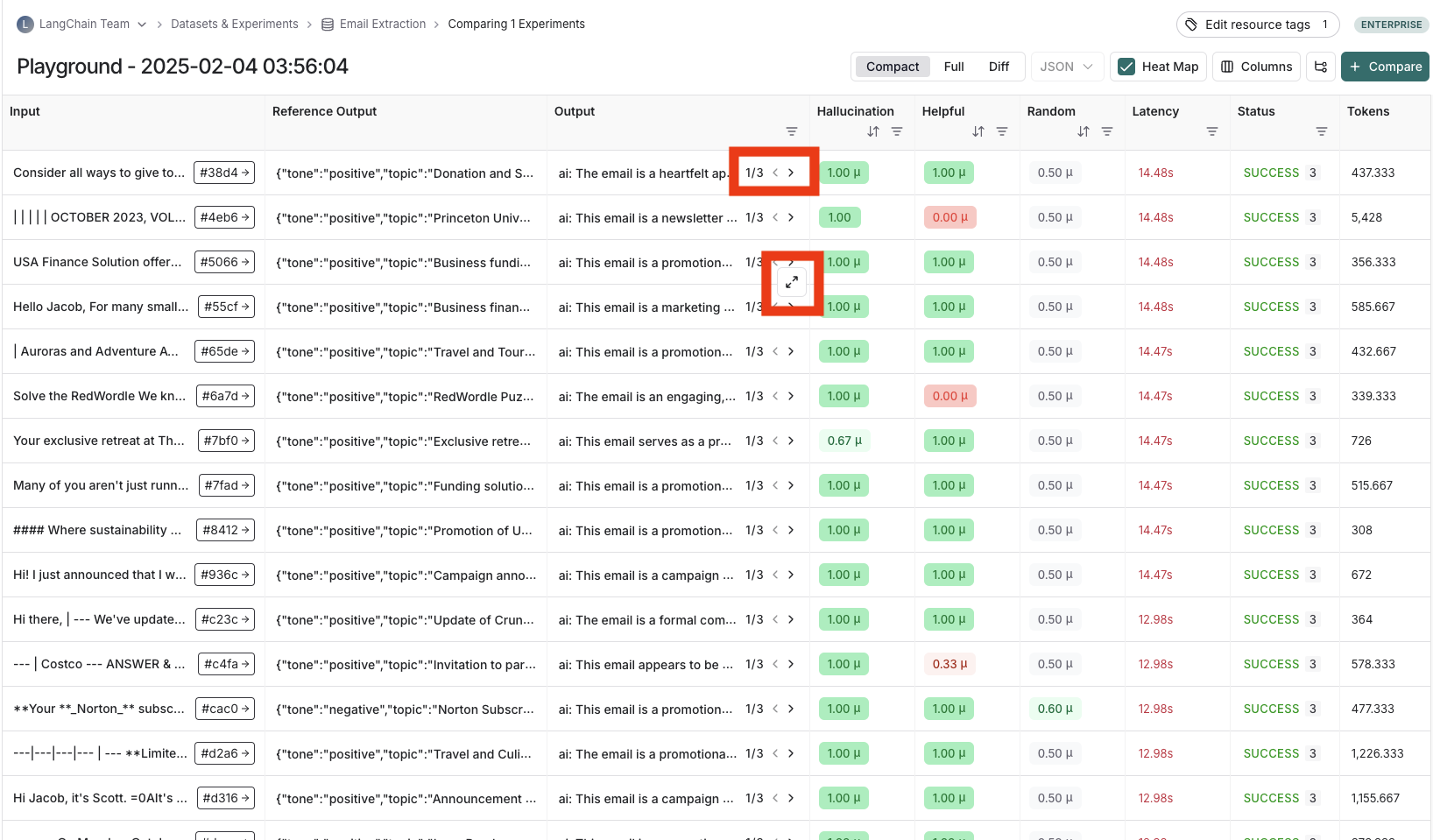

반복 실행으로 실행한 실험의 결과 보기

반복 실행으로 실험을 실행한 경우, 출력 결과 열에 화살표가 표시되어 테이블에서 출력을 볼 수 있습니다. 반복 실행의 각 실행 결과를 보려면 출력 셀 위에 마우스를 올리고 확장 보기를 클릭하세요. 반복 실행으로 실험을 실행하면 LangSmith는 테이블에 각 피드백 점수의 평균을 표시합니다. 피드백 점수를 클릭하면 개별 실행의 피드백 점수를 보거나 반복 실행 간의 표준 편차를 확인할 수 있습니다.